„Gefällt euch der ‚Jetzt kostenpflichtig bestellen‘-Button in Grün oder Orange besser?“ – Eine Frage, die wir bereits einige Male von unseren Kunden gehört haben. Unsere Antwort darauf ist eigentlich immer dieselbe:

„Ob uns der Button in Grün oder Orange besser gefällt, spielt keine Rolle. Wir gehören eventuell gar nicht zu eurer Zielgruppe und auf die Meinung von zwei einzelnen Person dürfen wir uns im Rahmen einer Conversion Rate Optimierung niemals verlassen. Wer das tut, stochert im Dunklen.“

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Conversion Rate Optimierung basiert nicht auf dem Gefallen einzelner Personen, sondern auf Zahlen, Daten und Fakten, die durch die Auswertung von Nutzerverhalten ermittelt werden (Oh Oh, Nutzerverhalten tracken, DSGVO). Um eine Conversion Rate Optimierung erfolgreich durchzuführen, wird Webanalyse betrieben mit verschiedenen Tools wie z.B. Google Analytics, Hotjar oder Mouseflow. Webanalyse ist trotz DSGVO aufgrund des sogenannten „berechtigten Interesses“ noch möglich. Ein weiteres sehr hilfreiches Mittel sind A/B-Tests – MACHEN!, so viele wie möglich z.B. mit VWO oder Optimizely.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Bevor wir uns ans Eingemachte machen, möchte ich noch kurz erklären, was ein A/B-Test ist. Wer das weiß, kann den folgenden Part überspringen.

Funktionsweise von A/B-Tests

A/B-Tests sind eigentlich sehr einfach zu verstehen: Es wird eine Website-Variante A und eine Website-Variante B erstellt und der Besucherstrom wird auf beide Varianten (meist) gleichmäßig verteilt. Weisen die beiden Website-Varianten kleine Unterschiede auf, kann nach einiger Zeit bzw. ausreichend Besuchern eine Entscheidung getroffen werden, welche der beiden Varianten die bessere Performance abgeliefert hat – sofern die entscheidenden Performance Indikatoren auch aufgezeichnet wurden. Künftig wird nur noch die Webseite mit der besseren Performance ausgespielt.

Schritt für Schritt können mit A/B-Tests also viele kleine Verbesserungen der Webseite vorgenommen werden, die zu einer Steigerung der Conversion Rate beitragen. Wir verlassen uns damit nicht auf ein Gefühl oder die eigene Meinung, ob dies oder das besser ist, wir probieren es aus und testen es gegeneinander direkt an unserer Zielgruppe. Hier kann also von einer datengetriebenen Conversion Rate Optimierung gesprochen werden.

Wie führt man einen erfolgreichen A/B-Test durch?

Um diese Frage ordnungsgemäß zu beantworten, müssen wir uns kurz auf die Definition eines „erfolgreichen A/B-Tests“ einigen. Für uns gilt ein A/B-Test dann als erfolgreich, wenn wir nach deren Durchführung eine Steigerung der Conversion Rate erzielt haben. Da es teilweise sehr schwer ist, den Erfolg oder Misserfolg eines A/B-Tests zu beeinflussen, wollen wir betrachten, wie man einen ordnungsgemäßen A/B-Test durchführt. Bei einem ordnungsgemäßen A/B-Test ist man im Nachhinein auf jeden Fall schlauer als vorher:

- Zeitlicher Faktor: Bei einem A/B-Test müssen beide Varianten zeitgleich getestet Es macht keinen Sinn, für einen Tag Variante A und am nächsten Tag Variante B zu testen. Abwechselnd oder willkürlich muss ein Besucher auf Webseite A und der nächste Besucher auf Webseite B landen. Eine Kaufbereitschaft kann je nach Produkt sehr stark von Tageszeit oder Wochentag/Wochenende abhängen.

- Kleine Änderungen: Wer gleich mehrere größere Veränderungen zwischen Variante A und Variante B testet, wird am Ende nicht wissen, welche der Änderungen entscheidend war. Die Devise lautet hier: Viele Tests mit kleinen Änderungen! Eine kleine Änderung könnte zum Beispiel die Anpassung des Wordings, Farbe eines Buttons, das direkte Anzeigen von Zahlungsmethoden sein.

- Ein Plan: Wer einen A/B-Test durchführt, sollte vorab einen Plan machen. Es bringt wenig wie wild Varianten von Webseiten gegeneinander zu testen, wenn am Ende kein Ergebnis erzielt wird, welches ausgewertet werden kann. Vorher überlegen: Welche Dinge könnten an der Webseite geändert werden? In welcher Reihenfolge wollen wir die Dinge testen? Welche KPIs wollen wir betrachten? Welche Wichtigkeit haben die einzelnen KPIs? Wie lange bzw. wie viele Nutzer lang soll der Test laufen? PLAN!

- Auswertung: Wer etwas testet, erhält für gewöhnlich ein Ergebnis. Wenn ich meine Hand auf die Herdplatte lege, um zu testen, ob sie noch heiß ist, weiß ich es danach. Wie finde ich heraus, ob die Variante A oder B besser performed hat? Es benötigt Webanalyse-Tools, Umfragen, welche die vorher festgelegten KPIs verlässlich aufzeichnen. Die bei uns am häufigsten beobachten KPIs sind die Conversion Rate (ahhhh! Mir geht ein Licht auf), durchschnittlicher Warenkorbwert, die Anzahl der Seiten je Sitzung sowie die Absprungrate. Letztlich hängen die beobachteten KPIs stark vom Projekt und deren Zielsetzung ab.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

- Ausreichend Daten: Wenn ihr daran gedacht habt, die vorher festgelegten KPIs aufzuzeichnen bzw. zu messen, habt ihr schon etwas richtiggemacht. Jetzt braucht ihr nur noch genügend Daten, eine ausreichende Datenmenge, um diese auch verlässlich deuten zu können: Zwei Besucher, einer auf Variante A, einer auf Variante B. Der auf Variante B kauft. Variante B ist besser, schaltet nur noch Variante B! Murgs… Erst wenn einige hundert oder besser tausende Besucher auf beiden Varianten waren, erhalten die Daten eine Aussagekraft.

Unser Praxisbeispiel: Neuartiges Fahrradschloss

Um diese Faktoren an einem Beispiel zu erklären, noch einmal zur Button-Farbe & weiteren möglichen Optimierungen zurück:

Wir haben eine Landingpage erstellt, auf der ein neuartiges Fahrradschloss vorgestellt wird und verkauft werden soll. Diese Landingpage erhält externen Traffic über eine Facebook-Werbeanzeige, deren Zielgruppe entsprechend unserem Facebook Insights Artikel sehr gut festgelegt wurde. Die Landingpage soll nun mit Hilfe von A/B-Tests optimiert werden. Als erstes machen wir eine Bestandsaufnahme der aktuellen KPIs und ermitteln Potenziale.

Als zweites machen wir einen Plan:

1. Welche Dinge könnten an der Webseite geändert werden?

Wir überlegen uns, was wir an der Landingpage ändern können, was einen positiven Einfluss auf unsere Conversion Rate haben könnte. Wir stellen quasi Hypothesen auf: Wenn wir das machen, wird sich die CR erhöhen. Es gibt Case Studies im Netz, wo Steigerungen der Conversion Rate von über 100 Prozent erreicht wurden, nur weil die Farbe des Buttons verändert wurde. Wir selbst konnten mit der Änderung der Farbe des Buttons noch nie eine solch immense Steigerung der Conversion Rate erreichen, aber hey:

- Unsere erste Idee ist die Änderung der Button-Farbe von Grün zu Orange.

- Unsere zweite Idee ist unter den Kaufen-Button folgende Hinweise zu platzieren: „Kostenloser Versand & 24 Monate Garantie“.

- Unsere dritte Idee ist: Oberhalb des Kaufen-Buttons integrieren wir eine Option, dass der Besucher die passende Tasche für das Fahrradschloss für einen Aufpreis von 5€ seinem Kauf hinzufügen kann. Dies ist ein sinnvolles Update des Produkts und könnte einige Besucher, die auf der Suche nach einem Fahrradschloss mit Tasche sind, überzeugen.

- Unsere vierte Idee ist, die Siegel, welche die Seriosität des Verkäufers bekräftigen, aus dem Footer zu entfernen und in den Head zu packen. Auf den ersten Blick soll der Nutzer wissen, dass er auf einer seriösen Webseite gelandet ist.

- Unsere fünfte Idee ist: Da wir Orange und Grün auch an anderen Stellen der Webseite verwenden, vermuten wir, könnten wir mit einem auffälligen gelben Kaufen-Button die Conversion-Rate steigern. Vielleicht knacken wir noch den Jackpot und erreichen die 100% Steigerung.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

2. In welcher Reihenfolge wollen wir die Dinge testen?

Als erstes wollen wir die perfekte Button-Farbe finden, also testen wir erst die Idee 1 und dann die Idee 5. Die anderen Ideen wollen wir in der Reihenfolge testen, für wie erfolgsversprechend wir sie halten. Da wir auf der Landingpage eine hohe Absprungrate und kurze Verweildauer (auch die Zeit der Abspringer kann mit Tools wie CrazyEgg gemessen werden) verzeichnen, vermuten wir ein Mangel an Vertrauen. Mit der Idee 4 wollen wir die Seriosität steigern und der hohen Absprungrate & kurzen Verweildauer entgegenwirken und damit die CR steigern. Anschließend setzen wir Idee 3 um: Damit erhoffen wir uns nicht nur eine Steigerung der CR, sondern auch eine Steigerung des durchschnittlichen Warenkorbwerts. Nun fehlt nur noch die Idee 2.

3. Welche KPIs wollen wir betrachten?

In erster Instanz ist die Conversion Rate interessant. Wie groß ist der Anteil der Besucher, die auf den Kaufen-Button klicken? In zweiter Instanz betrachten wir wie eben schon erwähnt die Absprungrate und die Verweildauer der Nutzer. Können wir mit den Veränderungen der Landingpage dafür sorgen, dass sich die Besucher länger & intensiver mit dem Produkt auseinandersetzen? Auch die Steigerung der Awareness für das Produkt kann ein Ziel sein. Idee 3 bringt den durchschnittlichen Warenkorbwert mit ins Spiel.

4. Welche Wichtigkeit haben die einzelnen KPIs?

Eine besondere Bedeutung haben die Conversion Rate und der durchschnittliche Warenkorbwert für uns, weil sich diese direkt messbar auf den Erfolg der Landingpage in Form von höheren Umsätzen auswirken. Die Absprungrate und die Verweildauer sollen aber ebenfalls nicht vernachlässigt werden.

5. Wie lange bzw. wie viele Nutzer lang soll der Test laufen?

Als letztes legen wir fest, wie lange der Test laufen soll. Nur wenn wir ausreichend Daten haben, kann der Test ein repräsentatives Ergebnis bringen. Wir legen fest, dass jede Änderung mindestens zwei Wochen oder 2.500 Nutzer getestet werden sollen (das, was später eintrifft). Um Idee 1 zu testen, bedeutet das: Wir starten den Test und lassen immer abwechselnd einen Nutzer auf Variante A mit grünem Button und den nächsten Nutzer auf Variante B mit orangem Button. Wenn nun auf Variante A und auf Variante B jeweils 2.500 Besucher waren bzw. der Test mindestens zwei Wochen lief, ziehen wir einen Strich drunter und werfen einen Blick auf die festgelegten KPIs.

Nach diesem Plan kann der A/B-Test nun durchgeführt werden. Dafür kann z.B. der Visual Website Optimizer (VWO) oder Optimizely genutzt werden. Zum Abschluss überprüfen wir noch einmal, ob wir alle wichtigen Kriterien beachtet haben:

- Zeitlicher Faktor: Ja, die Besucher werden abwechselnd auf die beiden Varianten geschickt.

- Kleine Änderungen: Ja, die Unterschiede bzw. die entwickelten Ideen sind klein und durchaus A/B-Test tauglich.

- Ein Plan: Ja, den haben wir eben aufgestellt. Es gibt verschiedene Wege diesen Plan übersichtlich festzuhalten. Ich bin ein Fan von Excel-Tabellen.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

- Auswertung: Vorab haben wir eine Bestandsaufnahme der KPIs vorgenommen und die entsprechenden Daten wurden über den Test hinweg getrackt. Auswertung, check!

- Ausreichend Daten: 2 Wochen oder 2.500 Besucher auf beiden Varianten sind das Minimum, wo wir von ausreichend Daten sprechen würden. Bedenkt man: Bei einer Conversion Rate von 5 Prozent auf der Landingpage wären das 125 der 2.500 Besucher, die auf „Kaufen“ klicken. Bei 125 Käufern ist die Wahrscheinlichkeit hoch, dass wir bei einer Variante mal 135 Käufer haben und die andere nur 122 Käufer hat. Dies wäre eine völlig normale Fluktuation. Also: Es dürfen gerne auch 3.000, 5.000 oder 10.000 Besucher sein, um die hinreichende Datenmenge auf jeden Fall zu erreichen.

Das passiert übrigens, wenn ihr die Kriterien nicht beachtet:

- Ihr bekommt Ergebnisse, die ihr euch nicht erklären könnt.

- Ihr bekommt Ergebnisse, die nicht auf eine spezielle Anpassung der Website-Variante zurückzuführen ist.

- Ihr bekommt Ergebnisse, von denen ihr meint, dass sie Erfolg versprechen. Nach Anwendung der Ergebnisse habt ihr entgegen der Erwartungen eine schlechtere Performance.

- Ihr bekommt keine Ergebnisse, weil ihr parallel keine Webanalyse betreibt. Blöd.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

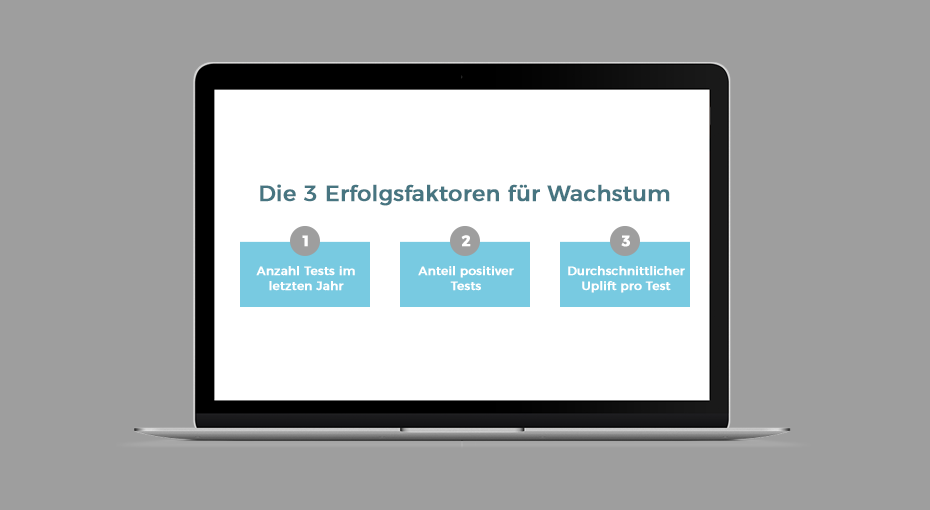

Die Erfolgsfaktoren für Wachstum

Wachstum bzw. eine Conversion Rate Optimierung in Bezug auf A/B-Tests lässt sich an einer einfachen Formel festmachen. Die Erfolgsformel soll kein geheimes Konzept sein, sondern lediglich zeigen, wir ihr den Erfolg eurer vielen A/B-Tests am Ende messen könnt. Die Verbesserung durch A/B-Tests wird definiert durch:

Es kommt also darauf an, dass möglichst viele Tests stattfinden, der Anteil der positiven Tests hoch ist und auch der durchschnittliche Uplift pro Test hoch ist. Kann man alle drei Faktoren hinreichend beeinflussen? Leider nein.

Nunja: Viele Tests durchführen ist einfach. Allerdings wird die Anzahl an möglichen A/B-Tests durch die Anzahl der Besucher auf eurer Webseite bestimmt. Während Amazon ein A/B-Test nur ein paar Minuten oder maximal ein paar Stunden fahren müsste, um eine ausreichend große Datenmenge zu erhalten, müssen auf Seiten mit nur wenigen Hundert Besuchern pro Monat Tests eventuell einen ganzen Monat gefahren werden.

Den Anteil positiver Tests hoch halten? Schwer zu beeinflussen… Ein guter Vorabplan mit inhaltsreichen Überlegungen, was verändert werden könnte, und etwas Erfahrung in Bezug auf Best Practices im Bereich Conversion Optimierung sowie das Kennen der Zielgruppe kann die Chance auf viele positive Tests erhöhen.

Großer durchschnittlicher Uplift pro Test? Auch schwer zu beeinflussen… Die Balance aus zu umfangreichen und zu kleinen Unterschieden zwischen den beiden Webseite-Varianten, die getestet werden, könnte einen positiven Einfluss haben. Allerdings: Hin und wieder sind es die auf den ersten Blick kleinsten Veränderungen, die einen großen Uplift erzeugen.

Bedeutung von A/B-Tests heute

A/B-Tests haben im eCommerce eine sehr große Bedeutung eingenommen. Sie können erheblich zur Conversion Rate Optimierung beitragen, da sie schnelle datengetriebene Ergebnisse liefern. Wer häufig auf Amazon unterwegs ist, wird sicher schon einmal bemerkt haben, dass der Conversion-Rate-Champion etliche A/B-Tests fährt. Ich verlinke hier einmal den Brief an die Anleger von Jeff Bezos, dem folgende zwei Aussagen so oder so ähnlich entnommen werden können:

- Versagen und Innovation sind untrennbare Zwillinge. Um Erfolg zu haben, muss man experimentieren.

- Große Gewinner zahlen für so viele Experimente.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.